Votre panier est actuellement vide !

Auteur/autrice : Kristián Ivančo

-

De zéro à un : comment notre silicium et nos puces personnalisés révolutionnent la réalité augmentée

En 2017, le scientifique en chef de Reality Labs Michael Abrashsoutenu par Mark Zuckerberg, fondateur et PDG de Meta, a créé une nouvelle équipe secrète au sein de ce qui était alors Oculus Research, afin de jeter les bases de la prochaine plateforme informatique. Leur tâche est herculéenne : Créer une solution de silicium personnalisée capable de répondre aux exigences uniques des futures plates-formes informatiques. lunettes de réalité augmentée-une prouesse technique qui a nécessité de réimaginer chaque composant pour un produit à porter toute la journée Lunettes AR qui n'existait tout simplement pas encore.

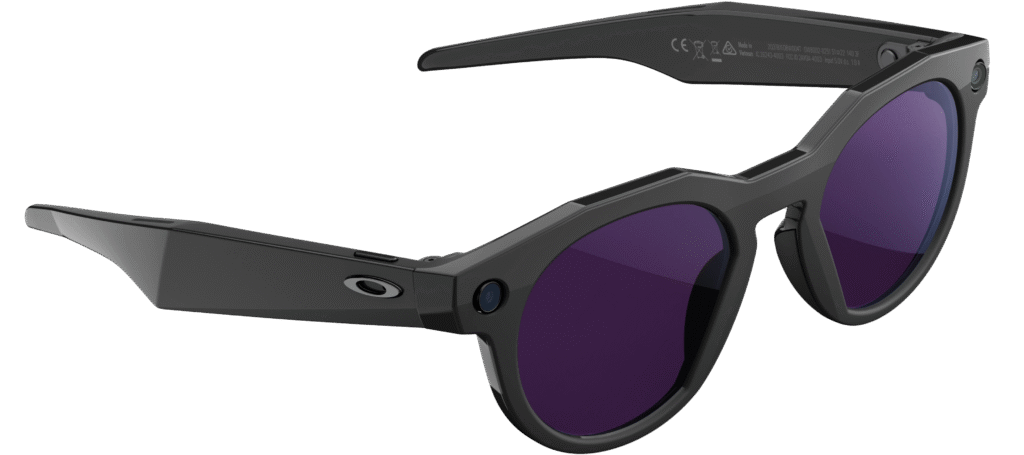

Angle avant du prototype de lunettes AR Orion.

Facteur de forme compact, espace problématique considérable

Passant de quelques chercheurs à des centaines de personnes du côté des produits, l'équipe chargée du silicium personnalisé est partie du principe que les lunettes de réalité augmentée ne pouvaient pas s'appuyer sur le silicium disponible dans les smartphones d'aujourd'hui. Ce postulat est confirmé par les différentes puces personnalisées qui se trouvent à l'intérieur des lunettes de réalité augmentée. Orionnotre premier prototype de lunettes AR.

"Construire le navire au fur et à mesure qu'il sort du port, c'est exactement ce que nous faisions", explique Jeremy Snodgrass, directeur de la stratégie des technologies avancées. "Nous devions augmenter l'effectif d'une équipe modeste tout en construisant ces puces simultanément. Il était fascinant de voir les dirigeants recruter de nouveaux employés tout en développant une culture qui valorise l'agilité. Rien n'était le problème de quelqu'un d'autre. Vous preniez un aviron et commenciez à ramer, même si ce n'était pas exactement ce pour quoi vous aviez été embauché. C'était une période très, très excitante".

"Presque tout ce qui concerne Orion était nouveau à bien des égards", reconnaît Mike Yee, directeur technique de Display Architecture. "Certaines idées existaient déjà, mais personne ne s'était lancé dans un projet de recherche visant à construire une paire de lunettes AR portable toute la journée.

L'équipe devait offrir une expérience de réalité augmentée convaincante avec une consommation d'énergie aussi faible que possible. Le facteur de forme des lunettes ne peut dissiper qu'une quantité limitée de chaleur et ne peut accueillir qu'une capacité de batterie limitée. Par conséquent, les expériences qu'il est possible d'offrir sur les lunettes dépendent entièrement du silicium. En d'autres termes, si l'on maintient constantes les capacités thermiques et de la batterie, la seule façon d'offrir une expérience donnée est d'optimiser le silicium.

"La conception d'une nouvelle architecture pour Orion a obligé l'équipe non seulement à pousser les technologies existantes comme le sans fil et les écrans de manière agressive, mais aussi à prendre des risques avec de nouvelles technologies", explique Neeraj Choubey, directeur de la gestion des produits. "Par exemple, l'équipe a développé un accélérateur d'apprentissage machine (ML) sans cas d'utilisation clair à l'époque, animée par la forte conviction que le ML deviendrait de plus en plus important dans les produits de Meta. Sur Orion, chaque accélérateur ML est utilisé, et dans certains cas, ils sont sursouscrits, servant des fonctions telles que le suivi des yeux et le suivi des mains. De même, l'équipe a développé des protocoles de compression personnalisés afin de réduire la bande passante et la consommation d'énergie lorsque les données sont transférées de l'ordinateur à l'ordinateur. calculer le palet à l'écran. Le développement d'un silicium personnalisé pour atteindre les objectifs d'Orion en matière de facteur de forme a exigé à la fois une tolérance à l'ambiguïté élevée et une attention méticuleuse aux détails pour fournir une architecture de système incroyablement complexe".

"Le plus grand défi que nous ayons eu à relever a été de fournir des graphiques en 3D verrouillés par le monde, ainsi qu'un son spatialisé dont le rendu donne l'impression qu'il émane d'un objet virtuel", note M. Snodgrass. "Nous avons dû intégrer toute cette électronique dans la capacité thermique et l'espace physique, puis la faire fonctionner sur la batterie pour qu'elle ne chauffe pas trop. Et nous avons dû faire tout cela dans un facteur de forme de lunettes réelles - pas une grosse visière comme on en voit généralement dans la catégorie.

"Nous savions comment fournir la puissance de calcul nécessaire pour donner vie à notre vision d'Orion, mais nous étions confrontés à une tâche redoutable : réduire la consommation d'énergie d'un facteur 100", explique Robert Shearer, directeur des solutions SoC. "Cela nous a obligés à repousser les limites de la conception de silicium, en adoptant des méthodologies issues de divers secteurs de l'industrie - de l'IdO au calcul haute performance - et en inventant de nouvelles approches pour combler les lacunes. Nos partenaires industriels nous ont pris pour des fous, et ils n'avaient peut-être pas tout à fait tort. Mais c'est exactement ce qu'il fallait : une volonté de remettre en question les idées reçues et de tout repenser. Construire un ordinateur qui fusionne de manière transparente les mondes virtuel et physique exige une compréhension profonde du contexte, dépassant de loin ce que les plateformes de calcul existantes peuvent offrir. En fait, nous avons réinventé la façon dont les ordinateurs interagissent avec les humains, ce qui signifie que nous avons dû réimaginer la façon dont nous construisons le silicium à partir de la base".

Composants extérieurs d'Orion.

La magie des MicroLEDs

À certains moments, lorsque les choses ont pris du retard ou qu'un défi technique apparemment insurmontable s'est présenté, il a été difficile de maintenir l'élan et le moral de l'équipe. Mais l'équipe a fait preuve de résilience, trouvant des moyens de contourner les obstacles - ou simplement de les abattre.

Prenons l'exemple de l'écran d'Orion. L'équipe chargée du silicium était responsable du silicium dans le projecteur d'affichage qui se trouve dans les coins des lunettes.

"Pour ces projecteurs, la question de savoir si nous pouvions obtenir des microLED dans un réseau avec une efficacité et une luminosité suffisantes pour déployer un écran à large champ de vision restait ouverte", explique M. Snodgrass. "Il y avait d'énormes doutes sur la possibilité de le faire, dans les délais que nous envisagions, car il s'agissait d'une technologie très naissante.

"Nous avons réalisé très tôt que nous devions repenser une grande partie des paradigmes du développement de produits", ajoute M. Yee. "La quantité de lumière nécessaire pour obtenir un affichage utilisable est beaucoup plus importante pour les lunettes AR car, en tant qu'affichage portable, vous êtes en concurrence avec le soleil. Nous avons donc besoin de niveaux d'énergie qui rivalisent avec le soleil - ou du moins c'est l'objectif. Nous n'y sommes pas encore tout à fait, mais c'est un élément important. Cela signifie qu'il faut des sources lumineuses pour un écran qui soient capables de le faire et des circuits qui puissent le contrôler. Et en même temps, il faut que ce soit minuscule".

Silicium personnalisé pilotant les µLEDs d'Orion.

Alors que les microLEDs semblaient être la source lumineuse la plus appropriée pour les projecteurs, le silicium a permis de libérer leur potentiel.

"Pour les écrans, nous parlons de pas de pixel, c'est-à-dire de la distance entre les points centraux des pixels adjacents", explique M. Yee. "Pour les téléviseurs, ces distances sont de l'ordre de centaines de microns. Dans votre téléphone, il y a beaucoup, beaucoup de dizaines de microns. Nous devions réduire ces distances à un seul chiffre. Le seul semi-conducteur connu capable d'atteindre cet objectif est le silicium".

Pour compliquer le travail, la surface arrière de l'écran devait être un morceau de silicium, et personne au monde n'avait conçu de silicium pour les microLED.

"À l'époque, les équipes de recherche avaient toutes réutilisé des écrans à cristaux liquides sur silicium pour y placer des microLED", explique M. Yee. "Personne n'avait encore conçu de fond de panier pour les microLED. Nous avons été confrontés à un défi assez unique, car il s'agit d'un composant optique. Il doit être plat. On ne peut pas le rayer. Il doit présenter toutes ces caractéristiques, car lorsque vous regardez à travers les guides d'ondes, à travers les projecteurs, vous regardez littéralement la surface supérieure du morceau de silicium."

L'équipe chargée du silicium a mis au point une série complexe de plates-formes de test pour ces écrans microLED, ce qui a nécessité une coordination étroite avec nos fournisseurs internationaux. Les microLED ont une empreinte mondiale : elles proviennent d'un endroit, puis sont transférées vers un autre site où elles sont placées sur une plaquette de silicium. Les plaquettes étaient ensuite expédiées pour être découpées dans une forme particulière, puis envoyées aux États-Unis pour être collées avec une autre plaquette, avant d'être réexpédiées à travers le monde pour que le module proprement dit soit construit et testé. Il s'agissait d'un processus extrêmement compliqué, et l'équipe chargée du silicium a mis au point des véhicules d'essai pour tester chaque étape.

L'équipe devait également trouver un moyen d'alimenter les écrans microLED dans le minuscule volume des coins des lunettes. Notre équipe analogique a développé une puce de gestion de l'alimentation personnalisée qui s'insère dans ce volume.

"La fourniture d'énergie est cruciale pour ces dispositifs portables de petite taille, où la taille de la batterie est limitée et l'espace restreint", note le directeur des systèmes analogiques et à signaux mixtes, Jihong Ren. "Notre solution personnalisée de circuit intégré de gestion de l'alimentation exploite des technologies de pointe pour optimiser l'efficacité énergétique de notre charge de travail spécifique au niveau du système, tout en respectant les contraintes d'espace disponibles. La réalisation de cette solution optimale a nécessité une étroite collaboration interdisciplinaire avec nos équipes mécaniques, électriques, SoC, μLED et thermiques, assurant une intégration transparente de tous les composants et maximisant les performances globales."

"Il s'agissait d'une prouesse non seulement sur le plan technique, mais aussi sur le plan de la gestion organisationnelle : réunir une équipe, travailler sur plusieurs fuseaux horaires et avec tous ces différents fournisseurs", ajoute M. Snodgrass. "D'une certaine manière, la gestion de tout cela sur le plan organisationnel a été un défi tout aussi important que le respect des spécifications techniques.

"Non seulement la conception est personnalisée, mais l'ensemble du processus de fabrication l'est également", ajoute M. Yee. "Nous avons la chance d'avoir de merveilleux partenaires dans l'industrie qui nous ont aidés à réaliser ce projet. Ils voient le potentiel à long terme des écrans AR dans leur ensemble et certainement la vision de Meta à ce sujet. Ils ont donc accepté de s'associer à nous pour réaliser ces personnalisations et optimisations afin de permettre cet affichage."

Lunettes Orion AR.

L'itération rencontre l'accélération

Il existait une boucle de rétroaction étroite entre l'équipe chargée du silicium et les brillants esprits de Reality Labs Research et de XR Tech qui développaient des algorithmes. Ces derniers fournissaient les algorithmes, que les premiers traduisaient en matériel, éliminant ainsi les frais généraux liés à l'exécution d'un logiciel par un processeur polyvalent. Cela signifiait que les algorithmes fonctionneraient à moindre puissance, mais aussi que l'équipe chargée du silicium était bloquée. Une fois les algorithmes renforcés, elle ne pouvait plus les modifier.

"Disons que XR Tech développait une certaine discipline de manière algorithmique", explique Ohad Meitav, directeur de l'architecture et des algorithmes chez Silicon Accelerators. "Ils sont propriétaires de la pile algorithmique et de ses performances. Mon équipe, en collaboration avec eux, déciderait alors de la manière d'accélérer l'algorithme, de renforcer certaines parties de l'algorithme et de l'intégrer dans le matériel de manière à ce qu'il fonctionne super efficacement. Ensuite, XR Tech adapte sa pile logicielle pour tenir compte du matériel. Il s'agit d'un processus très itératif".

Une autre réussite est la collaboration de l'équipe silicium avec Reality Labs Research pour mettre au point un nouvel algorithme de reprojection.

"Nous avions besoin que l'algorithme de reprojection prenne en charge un grand nombre de distorsions et de corrections différentes", explique Steve Clohset, architecte en silicium. "L'algorithme développé par RL-R que nous avons fini par utiliser n'est pas utilisé en informatique générale. Et à ce jour, il s'avère être un outil très puissant".

Une fois les algorithmes renforcés et le matériel optimisé, l'équipe chargée de la mise au point du silicium a mis les puces personnalisées à l'épreuve.

"Le jeu de puces en silicium personnalisé d'Orion est très complexe", explique Liping Guo, directeur principal du système et de l'infrastructure de bout en bout. "La mise en place et la validation de puces autonomes et de leurs interopérabilités dans un court laps de temps représentent un défi incroyable. Heureusement, nous opérons dans un environnement verticalement intégré où Reality Labs possède l'ensemble de la pile - du silicium et du micrologiciel de bas niveau au système d'exploitation, au logiciel et aux expériences de la couche supérieure. Nous avons tiré pleinement parti de cette situation, en travaillant en étroite collaboration avec nos partenaires interfonctionnels, et nous avons décalé l'intégration de la pile au stade de la validation du silicium. Orion a été notre expérience pilote pour cette méthodologie - nous avons développé nos muscles de shift-left et créé une base solide pour que Reality Labs puisse récolter tous les avantages d'un silicium personnalisé à l'avenir."

Après la mise en place, il était temps d'optimiser le logiciel.

"Il s'agit d'un processus itératif qui commence par une pile logicielle non optimisée, juste pour que tout démarre et fonctionne", explique M. Snodgrass. "Puis, un par un, vous passez en revue les sous-systèmes et commencez à optimiser le logiciel pour ce matériel spécifique, notamment en réduisant la quantité de mémoire utilisée par le logiciel. Le matériel peut être magnifiquement conçu, mais vous n'obtiendrez pas l'efficacité énergétique théorique si vous n'investissez pas autant de temps, voire plus, pour que le logiciel tire pleinement parti du matériel. Voilà donc l'histoire d'Orion : un matériel et un logiciel optimisés à l'extrême. Ne laissez aucun picojoule ou milliwatt derrière vous".

Et même si Orion n'est qu'un prototype, le travail qui y a été réalisé a un potentiel considérable pour influencer la feuille de route de Meta.

"Nous considérons les circuits intégrés en silicium que nous construisons comme des plates-formes, en ce sens qu'il s'agit de circuits précieux que nous améliorerons d'une génération ou d'un produit à l'autre", ajoute M. Meitav. "Tous les algorithmes graphiques et de vision par ordinateur ne sont pas seulement conçus pour Orion. Ils serviront à alimenter les produits futurs."

Notre travail dans le domaine du silicium consiste à créer de nouvelles solutions tout en travaillant en étroite collaboration avec nos partenaires. En fait, l'influence de l'équipe silicium s'étend au-delà d'Orion, à la fois pour Lunettes Ray-Ban Meta et Casques Meta Quest aujourd'hui, même s'ils utilisent tous deux des puces tierces. L'équipe chargée du silicium partage régulièrement ses travaux avec l'équipe chargée de la réalité mixte, en montrant ce qui est possible en termes d'efficacité énergétique. L'équipe de réalité mixte partage ensuite ces résultats avec des partenaires tels que Qualcomm afin de contribuer à la conception des futures puces. Et comme l'équipe chargée du silicium utilise les mêmes processeurs de signaux numériques (DSP) que les lunettes Ray-Ban Meta, elle a pu partager les enseignements tirés et les meilleures pratiques lors de la mise en œuvre et de l'écriture du code pour ces DSP afin d'améliorer les expériences audio disponibles sur nos lunettes d'intelligence artificielle.

Et ce partage de connaissances se fait dans les deux sens : L'équipe de RM a donné à l'équipe de silicium des informations sur des sujets tels que La distorsion temporelle asynchrone et Application SpaceWarp en production.

"Ce qu'une personne fait en production est bien plus intéressant que ce que nous pourrions faire avec un prototype", explique Clohset. "Nous avons essayé d'intégrer autant que possible ce qu'ils faisaient avec les ourdissoirs.

Ambiguïté < Ambition

Orion étant véritablement un système à zéro contre un, les équipes impliquées ont dû faire face à une quantité démesurée d'ambiguïté par nécessité.

"Dans le cas d'Orion, je ne saurais trop insister sur la complexité de l'ambiguïté", explique M. Clohset. "Lorsque vous fabriquez un ordinateur, par exemple, vous avez généralement une bonne idée de ce que sera l'écran. Mais nous ne savions pas ce que serait le guide d'ondes, nous avons donc dû échantillonner différents guides d'ondes et trouver un mécanisme capable de gérer le pire des scénarios, car nous ne savions pas où les choses allaient atterrir. Une optimisation ici se mêlait à tous les autres choix, et nous nous retrouvions avec une matrice de toutes ces choses différentes que nous devions soutenir et essayer de valider parce que nous ne savions pas où le produit atterrirait dans six mois".

Il est important de noter qu'Orion n'est pas une simple paire de lunettes de réalité augmentée, mais une constellation de matériel en trois parties. Une grande partie du traitement s'effectue sur le calculer le paletce qui nécessite un lien fort entre lui et les lunettes. Ajouter le bracelet EMG de surface dans la boucle, et l'architecture du système devient encore plus compliquée.

"C'était un énorme défi pour les équipes, et tout cela fonctionne", déclare M. Snodgrass. "Il s'agit d'une collaboration extraordinaire entre l'équipe silicium, l'équipe sans fil et les équipes logicielles de l'ensemble de l'organisation.

La rondelle de calcul d'Orion.

"Avec Orion, nous avons mis sur pied une équipe entière composée d'une grande diversité d'ingénieurs, qui ont pu concevoir un tout nouveau pipeline", ajoute M. Clohset. "Il s'agit d'un pipeline qui gère les mouvements d'objets à six degrés de liberté dans l'espace 3D. Il utilise son propre pilote d'affichage personnalisé. Nous avons dû effectuer des corrections de qualité d'image vraiment uniques. Et je pense que le défi pour nous était que, comme il s'agissait d'un projet zéro à un, il n'y avait pas de spécifications existantes à ajuster et à améliorer. Tout ici est entièrement nouveau, nous avons donc eu la latitude de tout faire".

À l'instar de la palet a quelques fonctions dormantes cachées sous la surface, le silicium personnalisé est également très performant. Bien qu'Orion ne permette pas à l'utilisateur de prendre des photos avec ses caméras RVB, le silicium est capable de les prendre en charge, ainsi que les fonctions suivantes avatars du codec. Et tout comme le puck a permis de débloquer un véritable facteur de forme de lunettes en déchargeant une grande partie du calcul, le silicium personnalisé d'Orion s'est avéré être une pièce nécessaire du puzzle de la réalité augmentée.

"Pour donner vie à une expérience zéro à un comme les lunettes AR, il faut du silicium sur mesure - un arrêt complet", explique M. Snodgrass. "Au fil du temps, s'il existe un marché, les fournisseurs de silicium développeront des produits pour répondre à la demande. Mais pour le zéro à un, on ne peut pas simplement prendre quelque chose qui existe sur l'étagère et qui est destiné à un produit différent et l'adapter à un nouveau moule. Il faut investir dans quelque chose de personnalisé. Et pour donner vie à ces expériences "zéro à un", il faut une large collaboration entre les partenaires logiciels, les concepteurs industriels, les ingénieurs en mécanique, etc.

"En nous affranchissant des modèles mentaux traditionnels, nous avons créé quelque chose de vraiment remarquable", ajoute M. Shearer. "Nous sommes convaincus que cette plate-forme informatique représente l'avenir de la technologie, et qu'elle révolutionnera la façon dont nous vivons, travaillons et interagissons les uns avec les autres. Nous sommes ravis d'être à l'avant-garde de cette innovation, de repousser les limites du possible et de contribuer à façonner le cours de l'histoire."

Pour plus d'informations sur Orion, consultez ces articles de blog :

-

Accélérer l'avenir

Lorsque nous avons commencé à faire des démonstrations de Orion Au début de cette année, je me suis souvenu d'une phrase que l'on entend souvent chez Meta - en fait, elle figurait même dans notre première lettre aux actionnaires potentiels en 2012 : Le code gagne des arguments. Nous avons probablement appris autant sur cet espace de produits en quelques mois de démonstrations en situation réelle que pendant les années de travail qu'il a fallu pour les réaliser. Rien ne remplace le fait de construire quelque chose, de le mettre entre les mains des gens et d'apprendre de leurs réactions.

Orion n'a pas été le seul exemple cette année. Notre matériel de réalité mixte et Lunettes d'IA ont tous deux atteint un nouveau niveau de qualité et d'accessibilité. La stabilité de ces plateformes permet à nos développeurs de logiciels d'aller beaucoup plus vite dans tous les domaines, des systèmes d'exploitation aux nouvelles fonctions d'intelligence artificielle. C'est ainsi que je vois le métavers commencer à se préciser et c'est pourquoi je suis convaincu que l'année à venir sera la plus importante de l'histoire de Reality Labs.

https://youtube.com/watch?v=xwMNZb6UE1o%3F%26controls%3D0%3Fautoplay%3D0%26color%3Dwhite%26cc_lang_pref%3Den%26cc_load_policy%3D0%26enablejsapi%3D1%26frameborder%3D0%26hl%3Den%26rel%3D0%26origin%3Dhttps%253A%252F%252Fwww.meta.com

2024 est l'année où les lunettes d'IA ont atteint leur vitesse de croisière. Lorsque nous avons commencé à fabriquer des lunettes intelligentes en 2021, nous pensions qu'elles pourraient constituer une première étape intéressante vers les lunettes de réalité augmentée que nous voulions construire par la suite. Alors que les casques de réalité mixte sont en passe de devenir une plateforme informatique générale, à l'instar des PC actuels, nous considérions les lunettes comme l'évolution naturelle des plateformes informatiques mobiles d'aujourd'hui. Nous voulions donc commencer à apprendre du monde réel le plus tôt possible.

Ce que nous avons appris de plus important, c'est que les lunettes sont de loin le meilleur facteur de forme pour un appareil véritablement axé sur l'IA. En fait, il pourrait s'agir de la première catégorie de matériel à être entièrement définie par l'IA dès le départ. Pour de nombreuses personnes, les lunettes sont l'endroit où un assistant d'intelligence artificielle a le plus de sens, en particulier lorsqu'il s'agit d'un assistant d'intelligence artificielle. système multimodal qui peut vraiment comprendre le monde qui vous entoure.

Nous sommes au début de la courbe en S pour toute cette catégorie de produits, et il y a d'innombrables opportunités à venir. L'une des choses qui m'enthousiasment le plus pour 2025 est l'évolution des assistants IA vers des outils qui ne se contentent pas de répondre à un message lorsque vous demandez de l'aide, mais qui peuvent devenir une aide proactive pendant que vous vaquez à vos occupations. Lors du salon Connect, nous avons montré comment l'IA en direct sur les lunettes peut devenir un participant en temps réel lorsque vous faites des choses. Comme cette fonction commence à se déployer en accès anticipé ce mois-ci nous verrons la première étape vers un nouveau type d'assistant d'IA personnalisé.

Ce ne sera pas le dernier. Nous sommes actuellement au milieu d'une poussée de l'ensemble de l'industrie pour créer du matériel natif de l'IA. Les fabricants de téléphones et d'ordinateurs se démènent pour reconstruire leurs produits afin d'y intégrer des assistants d'intelligence artificielle. Mais je pense que l'opportunité la plus importante est de fabriquer des appareils qui sont compatibles avec l'IA dès le départ, et je suis persuadé que les lunettes seront les premières à y parvenir. Michael Abrash, chercheur en chef chez Meta, a évoqué le potentiel d'un assistant personnalisé et contextuel sur des lunettes. depuis de nombreuses annéeset la mise au point des technologies qui la rendent possible ont été au cœur des préoccupations de nos équipes de recherche.

Réalité mixte est un autre domaine où le fait d'avoir le bon produit entre les mains d'un grand nombre de personnes a été un accélérateur majeur de progrès. Nous avons vu Meta Quest 3 s'améliorent mois après mois, alors que nous continuons à itérer sur le passage du système central, le multitâche, les interfaces utilisateur spatiales, et plus encore. Tous ces progrès ont été étendus à Quest 3S dès son lancement. Cela signifie que le Quest 3S $299 était à bien des égards un meilleur casque dès le premier jour que le Quest 3 $499 lors de son lancement en 2023. Et toute la famille Quest 3 continue de s'améliorer avec chaque mise à jour.

En 2025, nous verrons la prochaine itération de ce système avec le Quest 3S, qui permettra à un plus grand nombre de personnes d'accéder pour la première fois à la réalité mixte. Alors que le Quest 3 a été un succès auprès des personnes désireuses de posséder le meilleur appareil sur le marché, le Quest 3S devrait être le meilleur appareil de réalité mixte. très doué en 2024. Les ventes ont été importantes pendant le week-end du Black Friday, et nous nous attendons à ce que de nombreuses personnes activent leur nouveau casque pendant les vacances.

Cette initiative s'inscrit dans la continuité d'une tendance qui s'est dessinée l'année dernière : l'augmentation du nombre de nouveaux utilisateurs qui recherchent un éventail plus large de choses à faire avec leur casque. Nous voulons que ces nouveaux utilisateurs découvrent la magie du MR et restent sur le long terme, c'est pourquoi nous finançons les développeurs pour qu'ils créent les nouveaux types d'applications et de jeux qu'ils recherchent.

Il y a eu un afflux important de jeunes, en particulier, et ils ont été attirés par les jeux multijoueurs sociaux et compétitifs, ainsi que par le contenu freemium. Des titres comme BEHEMOTH de Skydance, Batman : Arkham Shadow (qui vient de remporter le prix du meilleur jeu AR/VR aux Game Awards !), et Metro Awakening a montré une fois de plus que certains des meilleurs jeux produits par notre industrie ne sont désormais possibles qu'avec les casques d'aujourd'hui.

Alors que le nombre de personnes en RM augmente, la qualité de l'expérience sociale qu'elle peut offrir s'accroît en même temps. C'est au cœur de ce que Meta essaie de réaliser avec Reality Labs et c'est là que le plus grand potentiel du métavers sera libéré : "La chance de créer la plateforme la plus sociale qui soit", c'est ainsi que nous l'avons décrite lorsque nous avons annoncé la création de Reality Labs. a commencé à y travailler. Nous avons fait deux pas en avant sur ce front en 2024 : tout d'abord avec un large ensemble d'améliorations apportées à Horizon Worlds, y compris son extension au mobile, et ensuite avec le système Meta Avatars de nouvelle génération qui permet aux gens de se représenter eux-mêmes à travers nos applications et nos casques. La qualité visuelle et l'expérience globale de ces systèmes s'améliorant, de plus en plus de personnes ont un premier aperçu d'un métavers social. Nous observons des tendances similaires : les nouveaux utilisateurs de Quest 3S passent plus de temps dans Horizon Worlds, ce qui en fait une application immersive du Top 3 pour Quest 3S, et les gens continuent de créer de nouveaux Meta Avatars sur mobile et MR.

L'introduction de la réalité mixte dans le grand public a permis d'éclairer ce qui se passera ensuite. L'une des premières tendances que nous avons découvertes après le lancement de Quest 3 l'année dernière était que les gens utilisaient la réalité mixte pour regarder des vidéos tout en étant multitâches dans leur maison - en faisant la vaisselle ou en passant l'aspirateur dans leur salon. C'était un premier signe que les gens aiment avoir un grand écran virtuel qu'ils peuvent emporter partout et placer dans le monde physique qui les entoure. Nous avons vu cette tendance prendre de l'ampleur et toutes sortes d'expériences de divertissement se développer rapidement sur l'ensemble de la famille Quest 3. Nouvelles fonctionnalités comme YouTube Co-Watch montrent le potentiel d'un tout nouveau type d'expérience de divertissement social dans le métavers.

C'est pourquoi James Cameron, l'un des conteurs les plus innovants de notre époque sur le plan technologique, s'efforce aujourd'hui d'aider davantage de cinéastes et de créateurs. produire du contenu 3D de qualité pour Meta Quest. Bien que des films en 3D soient produits depuis des décennies, il n'y a jamais eu de moyen de les visionner qui soit aussi bon qu'un casque MR, et l'année prochaine, le nombre de personnes possédant un casque sera plus élevé que jamais. "Nous sommes à un véritable point d'inflexion historique,"Jim a déclaré lorsque nous lancement de notre nouveau partenariat ce mois-ci.

Cette évolution s'accompagne d'un changement plus important Mark Rabkin partagés lors de la conférence Connect de cette année: Notre vision pour Horizon OS est de construire un nouveau type de plateforme informatique généraliste capable d'exécuter tous les types de logiciels, de prendre en charge tous les types d'utilisateurs et de s'ouvrir à tous les types de créateurs et de développeurs. Nos récentes versions pour le multitâche 2D/3D, le positionnement des panneaux, un meilleur suivi des mains, l'intégration de Windows Remote Desktop et l'Open Store ont commencé à donner un élan à cette nouvelle voie. Horizon OS est en passe de devenir la première plateforme à prendre en charge l'ensemble des expériences, de la RV immersive aux écrans 2D, en passant par les applications mobiles et les bureaux virtuels, et la communauté des développeurs est au cœur de ce succès.

Le prochain grand pas vers le métavers combinera des lunettes d'intelligence artificielle avec le type d'expérience de réalité augmentée que nous avons révélée cette année avec Orion. Il n'est pas fréquent d'avoir un aperçu de l'avenir et de voir une technologie totalement nouvelle qui nous montre où vont les choses. Les personnes qui ont vu Orion ont immédiatement compris ce que cela signifiait pour l'avenir, tout comme les personnes qui ont vu les premiers ordinateurs personnels prendre forme à Xerox PARC dans les années 1970 ("en dix minutes, il était évident pour moi que tous les ordinateurs fonctionneraient un jour comme cela", a déclaré plus tard Steve Jobs à propos de sa démonstration du Xerox Alto en 1979).

Pouvoir mettre les gens dans une machine à remonter le temps et leur montrer à quoi ressemblera la prochaine plateforme informatique a été un moment fort de 2024 et de ma carrière jusqu'à présent. Mais le véritable impact d'Orion se fera sentir dans les prochains produits que nous livrerons et dans la façon dont il nous aidera à mieux comprendre ce que les gens aiment dans les lunettes AR et ce qui doit être amélioré. Nous avons passé des années à travailler sur des études d'utilisateurs, des exercices de planification de produits et des études expérimentales pour essayer de comprendre comment les lunettes AR devraient fonctionner, et c'est ce travail qui nous a permis de construire Orion. Mais le rythme des progrès sera beaucoup plus rapide à partir de maintenant, maintenant que nous disposons d'un véritable produit sur lequel fonder notre intuition.

C'est la leçon que nous avons tirée à maintes reprises au cours de la dernière décennie à Reality Labs. La chose la plus importante que vous puissiez faire lorsque vous essayez d'inventer l'avenir est d'expédier des produits et d'apprendre comment les gens les utilisent. Ce ne seront pas toujours des succès immédiats, mais ils vous apprendront toujours quelque chose. Et lorsque vous tombez sur des choses qui font mouche, comme la réalité mixte sur Quest 3 ou l'IA sur des lunettes, c'est là que vous mettez le pied sur l'accélérateur. C'est ce qui fera de 2025 une année si particulière : Avec les bons appareils sur le marché, les gens qui les expérimentent pour la première fois et les développeurs qui découvrent toutes les possibilités qui s'offrent à eux, il est temps d'accélérer.

-

Boz to the Future Episode 22 : L'avenir d'Orion et des objets portables avec l'invité Alex Himel

Bienvenue pour un nouvel épisode de Boz To The Futureun podcast de Reality Labs. Dans le cadre de l'épisode d'aujourd'huiNotre hôte, Andrew "Boz" Bosworth, directeur technique de Meta et responsable de Reality Labs, est rejoint par Alex Himel, vice-président de Meta chargé des produits portables.

L'équipe de Himel travaille sur certains des problèmes techniques les plus difficiles de l'industrie, dans le but d'aider à construire la prochaine plateforme informatique. À l'instar de M. Bosworth, M. Himel est un dirigeant de longue date chez Meta, ayant occupé de nombreux postes de direction au sein de l'entreprise depuis plus de 15 ans.

Bosworth et Himel couvrent un large éventail de sujets, notamment les produits portables, la réalité augmentée et la manière dont l'IA accélère et améliore les types d'expériences intégrées dans les systèmes de gestion de l'information. Lunettes Ray-Ban Meta et les produits futurs.

Ils vont en profondeur sur Orion et l'accueil positif qu'elle a reçu depuis que Mark Zuckerberg l'a annoncée à l'occasion de la conférence de l'Union européenne. Connecter. Tout comme Steve Jobs a reconnu l'Alto comme un tournant dans l'informatique, Bosworth a affirmé que, même si nous ne sommes pas d'accord sur les détails, il est difficile d'affirmer que c'est l'avenir. Himel et Bosworth poursuivent en parlant de l'énorme valeur du prototypage et de la construction, en disant qu'ils ont beaucoup plus appris sur Orion et ses paradigmes d'entrée en trois semaines d'utilisation qu'au cours des années passées à le construire.

Ils ont également évoqué le rôle crucial de l'IA dans les wearables et la façon dont elle devient de plus en plus utile dans la vie de tous les jours, en particulier maintenant que vous pouvez interroger Meta AI sur les choses que vous voyez et l'utiliser pour programmer des rappels visuels.

Himel parle également de sa grande expérience dans un autre type de pile : les sandwichs. Avec sept ans d'expérience dans le célèbre Lange's Little Store de Chappaqua, NY, où il a grandi, Himel et Bosworth se penchent sur ce qui fait un bon sandwich, sur la place des tomates et sur la supériorité du pain.

Vous pouvez écouter Boz vers l'avenir sur Apple Podcasts, Spotifyet partout où vous écoutez des podcasts.

Vous pouvez suivre Himel sur Fils. Vous pouvez suivre Bosworth sur Instagram, Twitter/Xet Fils @boztank.